ブレインコプロセッサ構想

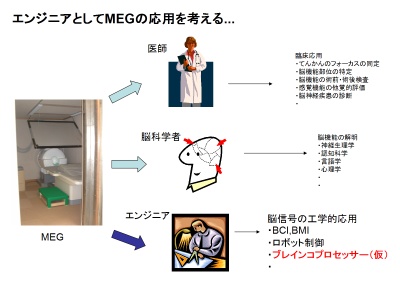

エンジニアとしてのMEGの応用

これまでMEGは使ってもらうという立場だった。

お医者さんに使ってもらう場合は、臨床に役立てるため。

- てんかんのフォーカスの同定

- 脳機能部位の特定

- 脳機能の術前・術後検査

- 感覚機能の他覚的評価

- 脳神経疾患の診断

- etc...

脳科学者に使ってもらう場合は、脳機能の解明のため。

- 神経生理学

- 認知科学

- 言語学

- 心理学

MEGを使うという立場に立つと、

エンジニアの私としてはどのような応用が考えられるだろうか...

脳信号を用いた工学システムの構築、

もしくは脳信号の工学的応用。

具体的には、BCI、BMI、ロボット制御。

そして、私の考案するブレインコプロセッサー(仮称)

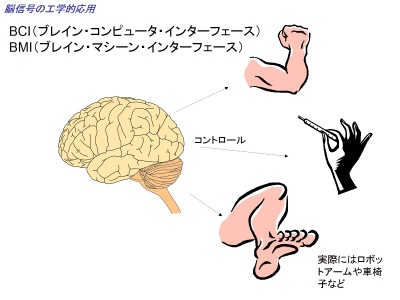

脳信号の工学的応用

脳信号の工学的応用として、

最近巷でよく耳にするBCI(ブレイン・コンピュータ・インターフェース)や

BMI(ブレイン・マシーン・インターフェース)

ブレイン・ネットワーク・インターフェースというのは、

脳波やfMRIなどの脳信号を使って、

腕や手もしくは足などの機能を持つものをコントロールすることが主なねらいである。

脳波でコンピュータのカーソルを脳信号を使って操作するというのは、

言い換えると手でカーソルキーを操作していたものを脳信号で直接操作しようというものである。

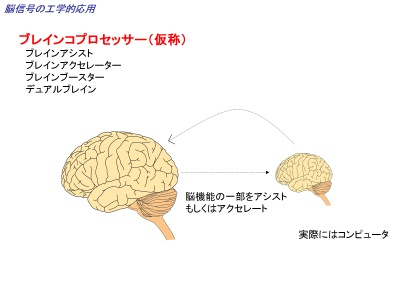

私の考える新たな脳信号の工学的応用として、

BCIやBMIのような手や腕などの身体機能のアシストではなく、

脳そのもののアシストを考えている。

名称はまだ確定ではないが、

一応ブレインコプロセッサーと名づける。

コンピュータにおいてCPUに対するコプロをイメージしている。

他に名称の候補としては、

- ブレインアシスト

- ブレインアクセレータ(アクセラレータ)

- ブレインブースター

- デュアルブレイン

などがある。

最後のものは、最近のデュアルCPUからヒントを得たものである。

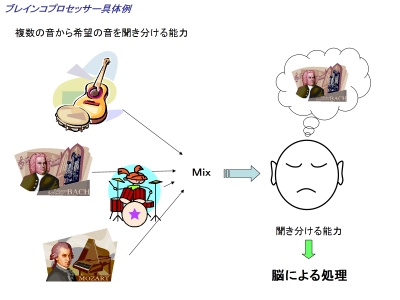

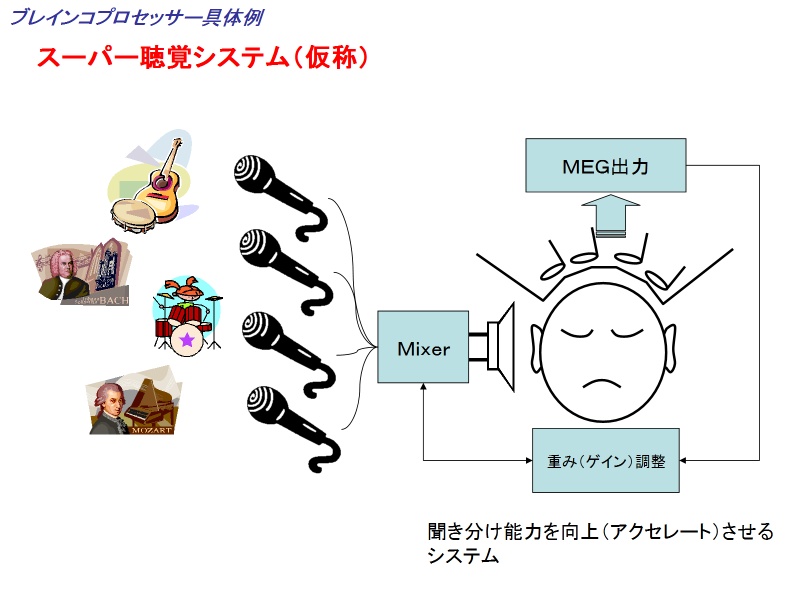

ブレインコプロセッサー具体例

ブレインコプロセッサーの具体例について。

人にはカクテルパーティー効果などでよく知られているように、

複数の音から希望の音を聞き分ける能力を有している。

例えばこの図のように数種類の音楽が同時に鳴り響いていても、

希望の音楽だけを聞き分けることができる。

これは主に脳による処理である。

この脳機能をさらに向上させる装置ということで、

脳信号(MEG信号)をつかい聞き分けている音を推定し、

その音をより聞きやすい状態にするシステム、

名づけてスーパー聴覚システム(仮称)なるものを考えている。

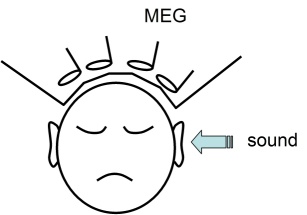

パイロットスタディ1

パイロットスタディとして。

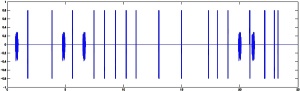

通常は音刺激を提示して、その音に関して加算平均をして、その音に対する脳磁場波形を得る。

| 1kHz tone burst | Vowel /a/ | |

|---|---|---|

|

|

|

これは別の研究目的のために実施した聴覚刺激実験であるが、

1kHzのトーンバーストと母音/a/をランダムに提示して計測した脳磁場生波形データである。

ブレインコプロセッサーシステムは脳信号のリアルタイム処理が要求され、

このような生波形データでどの程度の処理ができるのか知る必要がある。

そこで問題設定として、

この生データから、どのタイミングでどの音がなっていたかを推定(再現)することを試みた。

使う情報は各音に対する加算平均データである。

| 1kHz tone burst | Vowel /a/ |

|---|---|

|

|

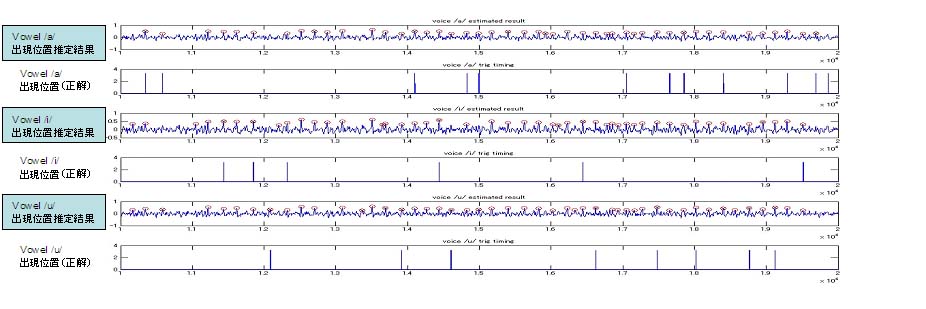

細かいアルゴリズムの説明は省略するが、

生データからトーンバーストが鳴っている位置(時刻)と

母音/a/がなっている位置を推定した結果を示す。

○に×がついているものが推定位置。

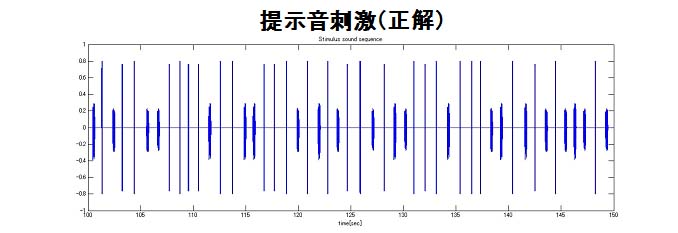

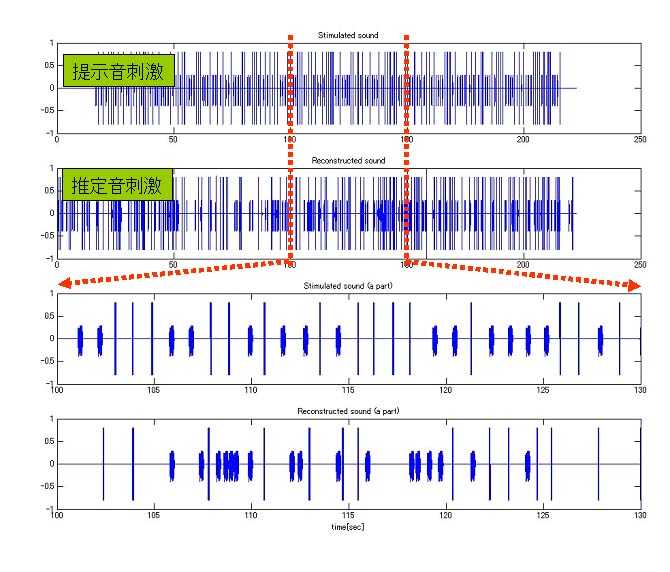

この判定結果を元に、下図に音信号に変換したもの(一部)を示す。

エラーがいくつかあるが、そこそこ再現することができた。

なお、精度を上げるための改良の余地は十分残っているが、

ここでは可能性の検証を目的としているので、特に深入りせずに次のステップに進むこととした。

| オリジナル音刺激(正答) | 再生音刺激 |

|---|---|

|

|

パイロットスタディ2

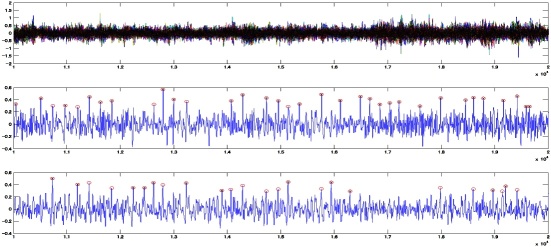

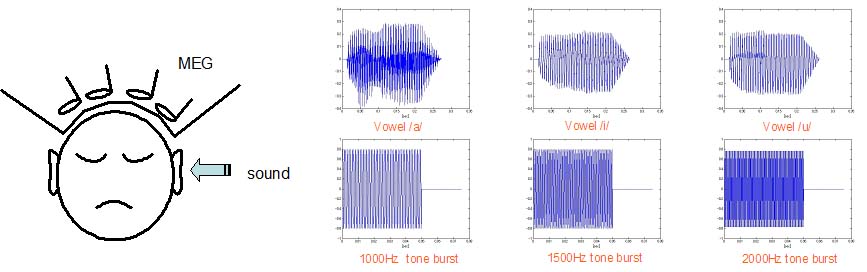

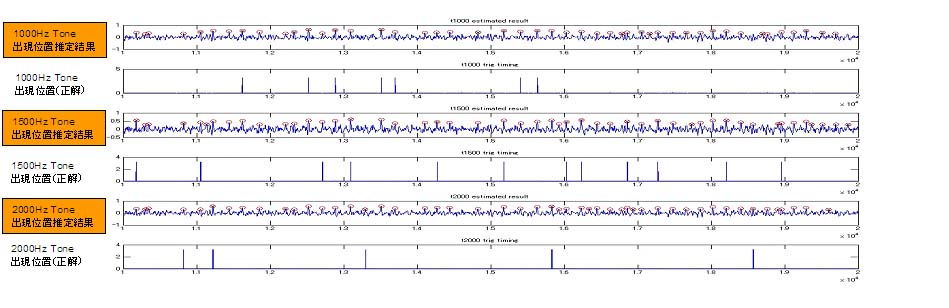

6種類の音に拡張。用いた音は母音/a/,/i/,/u/、純音1000Hz, 1500Hz, 2000Hzで、約1秒間隔でランダムに提示(左耳)。

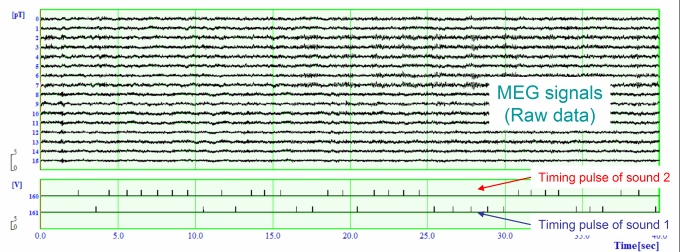

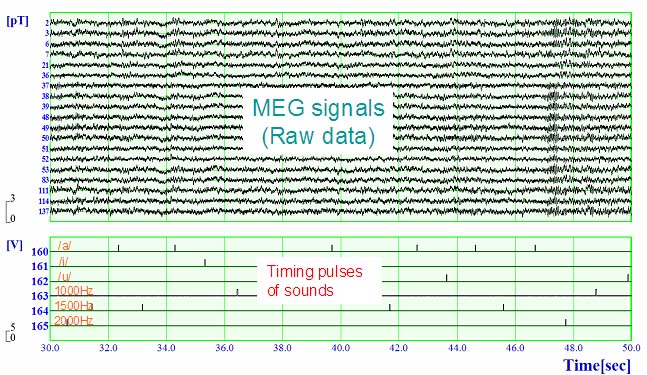

そのときのMEGの生波形群および各音の提示タイミングを示す。

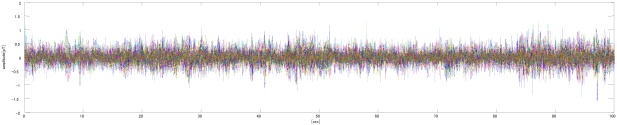

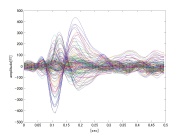

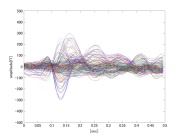

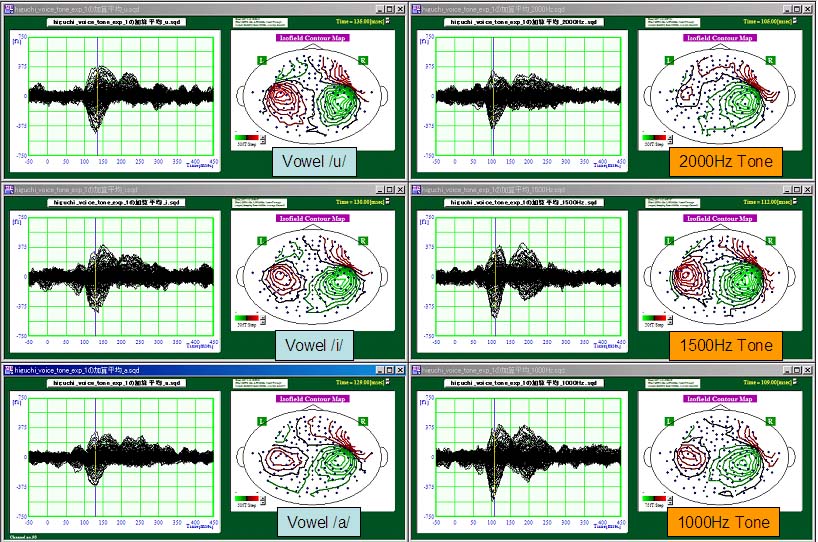

各音に対する聴覚誘発脳磁場の加算平均波形とN1mの等磁場線図を示す。加算回数は30回程度である。

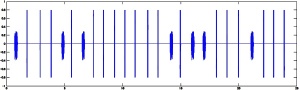

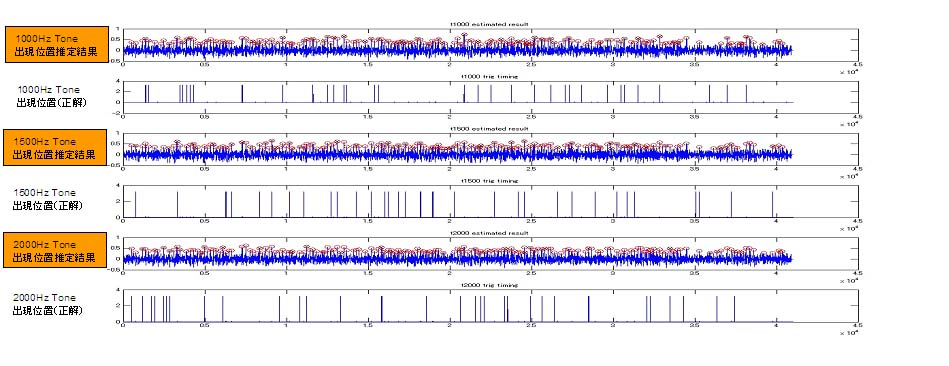

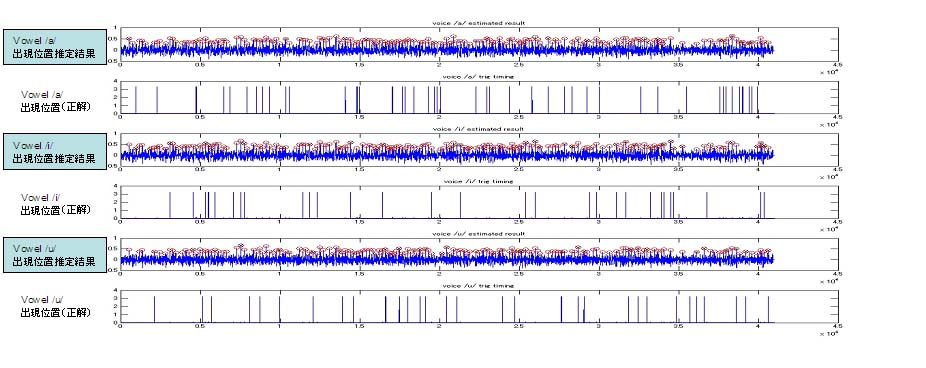

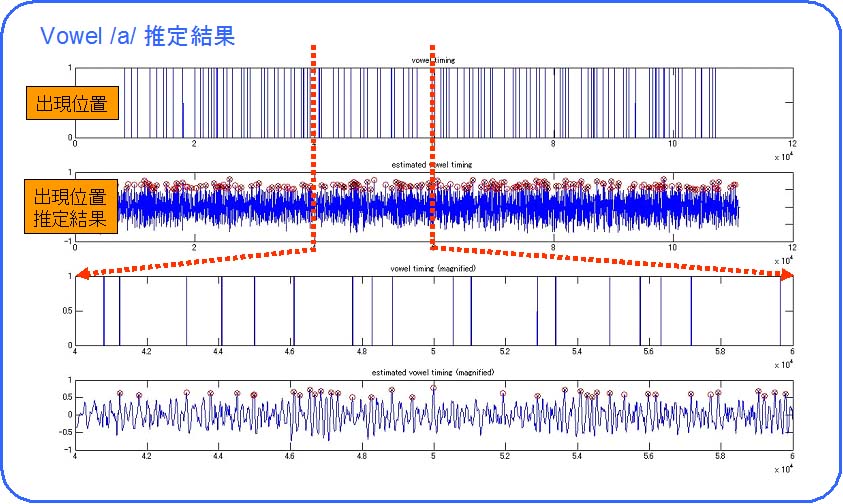

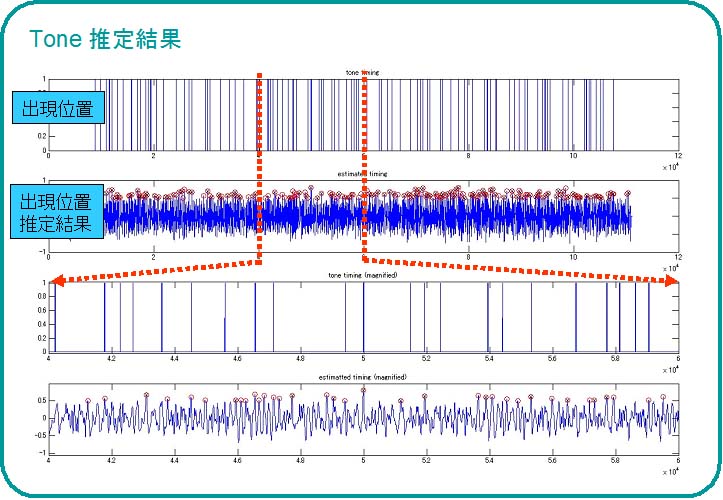

パイロットスタディ1と同様、これらの加算平均データを用いて生データにおいてどのタイミングでどの音を聞いていたかを推定する。用いるアルゴリズムは1と同じ。下図はその処理結果を示す。

分かりにくいにので、一部を拡大したものを示す。

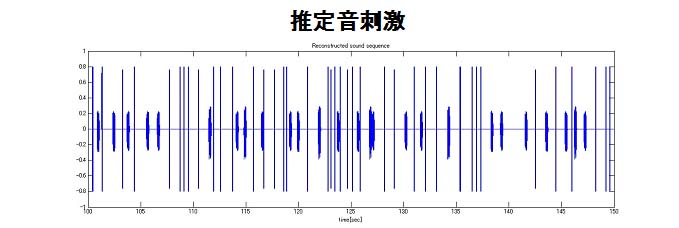

推定結果の一部を音波形に変換した結果を示す。エラーは多いが、まあまあいけるかな・・・

もちろんアルゴリズムの改良の余地は十分あり、クオリティを向上させることは十分可能だ。

応用として、より多くの基本音の加算平均データを蓄積し、生波形データから聞いている単語や文章を再生する、というような装置ができるかもしれない。ただし、音の間隔が短くなった場合どこまで脳が線形性を保った反応をするかは検討を要す。

しかし、ここであまり時間をかけることはできない。先を急ごう!

パイロットスタディ3

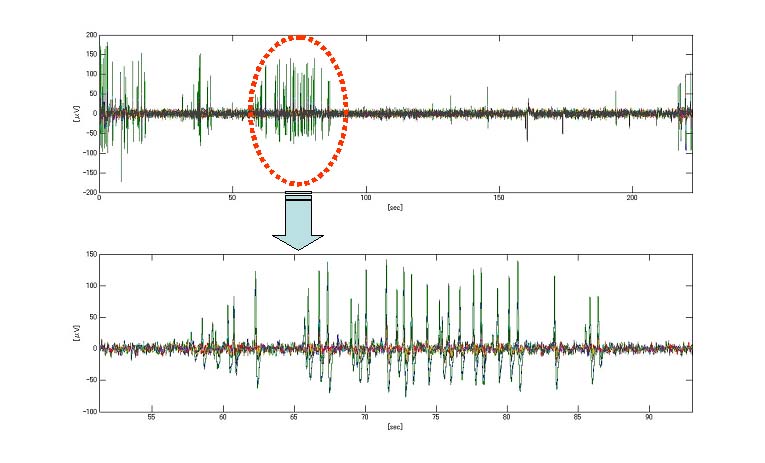

実用的にはMEGよりもEEG(脳波)の方が適している。EEGでも先の実験が実現可能かどうかを試してみた。スタディ1と同じ2種類の音、母音/a/と1kHのトーンバーストをランダムに被験者に提示し、そのときのEEGを計測した。EEG電極は市販のエレクトロキャップを用い、チャネル数は14チャネルである。下図の生波形を示す。所々こめかみ付近の筋電と思われるアーチファクトが混入している。

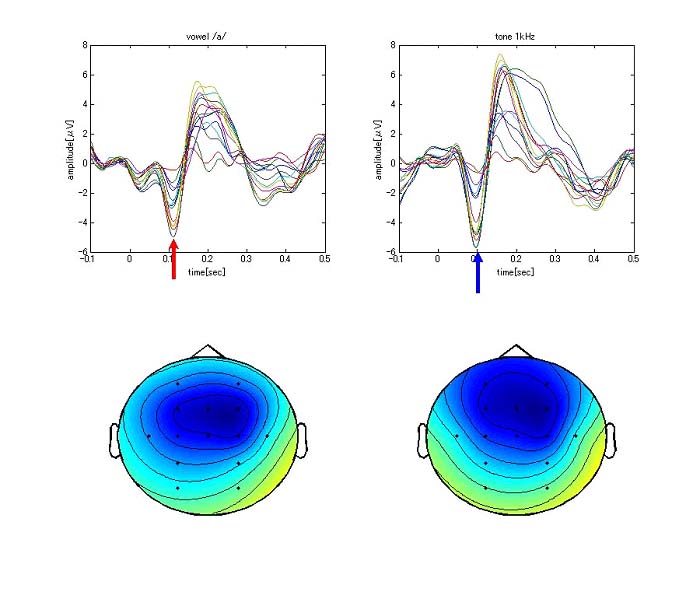

各音刺激について加算平均したEEG波形とN100におけるコンターマップを示す。

スタディ1と同じアルゴリズムを用いて、各音の出現位置を推定した。下図は母音/a/の結果。

1kHzトーンバーストの結果は下図の通り。(すいません、図の大きさが上図と合ってません。)

さあ、音波形に変換してみましょう。

うーん、ちょっと苦しいかな・・・。でも、可能性0というわけでもなさそう。電極の個数や配置、アルゴリズムを改良すれば何とかなりそうかな。取り敢えずEEGでもできそうということで、次に進もう。